LLMの浅い理解と深い理解: AIは本当に言葉を理解しているのか?

生成AIは驚くほど流暢な文章を作成します。しかし一方で、事実とは異なる内容をもっともらしく語る「ハルシネーション」や、論理的に破綻した回答を生成することも少なくありません。なぜAIは、「言葉」の操り方は完璧なのに「意味」を間違えるのでしょうか?

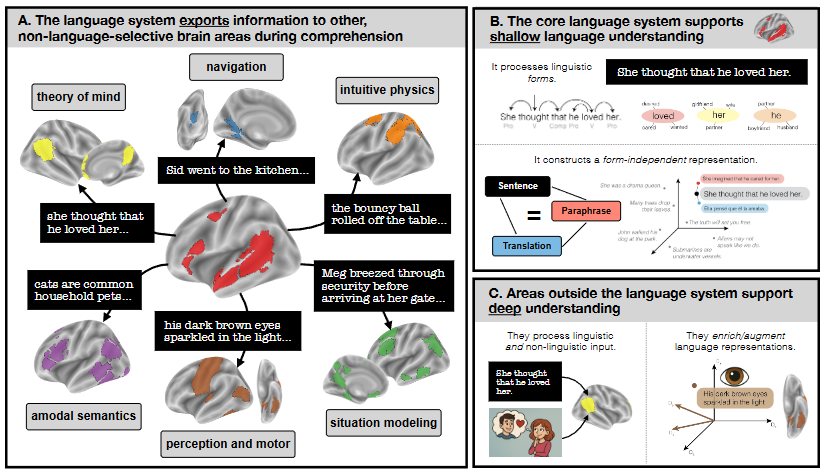

その答えのヒントは、私たちの「脳」にあります。最新の認知神経科学の研究によれば、人間の脳内でも「言葉の処理(浅い理解)」と「世界のシミュレーション(深い理解)」は、実は異なるシステムで行われている可能性が高いのです。脳は言葉で受け取った情報を、視覚や論理を司る別の領域へ「転送(Exportation)」することで初めて深く理解しています。

今回は、この「転送仮説」という脳のメカニズムを紐解きます。そして、単なるチャットボットを超え、実務で実用的な成果を出す「堅牢なAIシステム」を構築するための具体的なアプローチについて考察します。

言語システムは「言葉」を知っているが「世界」を知らない

なぜAIは、息をするように嘘をつくことができるのでしょうか。その根本的な理由は、人間の脳内にある「中核言語システム(Core Language System)」の仕組みを知ることで見えてきます。

脳内の「文法担当者」:中核言語システム

私たちの脳には、左半球の側頭葉や前頭葉を中心に、言語処理に特化したネットワークが存在します。これを「中核言語システム」と呼びます。このシステムは、耳や目から入ってきた単語を認識し、それらがどのような文法構造でつながっているかを瞬時に解析する役割を担っています。いわば、脳内の「文法担当者」であり、言葉の並びから情報を抽出するプロフェッショナルです。

「浅い理解」の限界と無意味な文章

しかし、中核言語システムには大きな落とし穴があります。それは、現実世界の「意味」よりも、言葉上の「統計的なつながり」を優先してしまう点です。

有名な例として、言語学者ノーム・チョムスキーが提示した「色のない緑の考えが猛烈に眠る(Colorless green ideas sleep furiously)」という短文があります。この文は、「緑」なのに「色がない」、「考え」が「眠る」など、現実世界の論理としては完全に破綻しています。しかし、文法的には完璧です。驚くべきことに、私たちの中核言語システムは、このような無意味な文に対しても、「サリーが犬の散歩に公園へ行った」というような意味の通る文と同じくらい強く反応することが研究で示されています。

つまり、脳の言語処理単体では、内容が事実かどうか、あるいは物理的に可能かどうかは二の次であり、「言葉として整っているか」しか見ていないのです。これを研究者は「浅い理解(Shallow Understanding)」と呼んでいます。

LLMは「言葉」の確率計算機

現代のLLM(大規模言語モデル)が抱える課題も、これと全く同じ構造にあります。LLMは膨大なテキストデータから「言葉の統計確率」を学習し、ある単語の次にくる可能性が最も高い単語を予測しているに過ぎません。

LLMは、文法やパターンを操る「形式的な能力(Formal Competence)」においては人間の中核言語システムと同等のレベルに達しています。しかし、その言葉が指し示す現実世界の物理法則や因果関係を直接「体験」として持っているわけではありません。AIがもっともらしい嘘(ハルシネーション)をつくのは、彼らが「言葉」を完璧に理解している一方で、その言葉が指し示す「世界」を知らないからなのです。

「深い理解」のメカニズム

言葉の確率的なつながり処理する「浅い理解」に対し、人間が行っている「深い理解」とは一体どのようなプロセスなのでしょうか。その鍵となるのが、脳科学における新しい仮説、「情報の転送(Exportation)」です。

情報の転送(Exportation)仮説

最新の研究によると、中核言語システムには処理能力に限界があり、言葉の意味を深く理解するためには、処理した情報を脳内の「言語外領域」へと転送する必要があるとされています。 つまり、言語システムは司令塔のような役割を果たしており、入ってきたテキスト情報を解析した後、それを視覚、運動、感情、論理推論などを司る専門の部署へ「業務委託」しているのです。このプロセスを経ることで、単なる記号の列が、私たちの体験に基づいた豊かな意味を持つようになります。

メンタルモデル(状況モデル)の構築

情報を受け取った各専門領域では、何が行われているのでしょうか。それは「シミュレーション」です。 例えば、「シャチが手作りのたわしで体をこすっている」という文章を読んだとき、私たちは単語を処理するだけでなく、頭の中でシャチの姿や動き、たわしの感触などを視覚的・触覚的に思い浮かべます。脳は言葉を手がかりにして、登場人物、場所、因果関係を含む「状況モデル(Situation Model)」または「メンタルモデル」と呼ばれる仮想世界を構築します。言葉を「読む」のではなく、言葉を使って世界を「再構築」することこそが、深い理解の本質です。

専門領域へのルーティング(Routing)

この情報の転送は、内容に応じて適切な領域へ振り分けられます。これを「ルーティング(Routing)」と呼ぶ考え方があります。

- 他者の意図を読む場合: 小説で登場人物の気持ちを推測するような場面では、「心の理論」を司る右側頭頭頂接合部(rTPJ)などのネットワークへ情報が送られます。

- 空間や移動の話の場合: 道順や場所の描写であれば、ナビゲーションに関わる場所領域(PPAやRSCなど)が活性化し、空間的な地図を作成します。

- 物理的な因果関係の場合: 物体の動きや作用については、直感的な物理推論を行うネットワーク(Physics Network)がシミュレーションを行います。

このように、脳は言語処理の負荷を下げつつ、餅は餅屋と言わんばかりに専門の脳領域を活用することで、高度で多角的な理解を実現しているのです。

ビジネス利用への応用

脳が言語処理を効率化するために「転送」を行っているという事実は、AIビジネスの実装戦略にも重要な示唆を与えてくれます。

LLM単体依存からの脱却

これまでのAI開発では「モデルのパラメータ数を増やせば理解力が上がる」という傾向がありました。しかし、脳科学的な視点に立てば、LLM単体での性能向上には限界があると考えられます。 脳が「中核言語システム」だけで世界を理解していないのと同様に、AIにおいてもLLMに全ての処理を負わせるのではなく、機能ごとに特化した外部モジュールと連携させるアーキテクチャが有効です。これは、LLMが持つ「形式的な能力」と、外部ツールが持つ「機能的な能力」を組み合わせるアプローチです。

具体的な実装パターン(Neural-Symbolic / Tool Use)

人間の脳が行っている「転送」プロセスを、AIシステム設計に落とし込むと、以下のような実装パターンが見えてきます。

- 物理・計算エンジンの活用: 物理的な現象予測や複雑な数値計算が必要なタスクにおいて、LLMに直接答えを出させる(確率的に推測させる)のはリスクがあります。代わりに、自然言語を「確率的プログラミング言語(Probabilistic Programming)」などのコードに翻訳させ、実際の計算処理は外部のシミュレーターや計算エンジンに「転送」して実行させる手法が有効です。

- 論理推論とのハイブリッド: 契約書の整合性確認など、厳密な論理が求められる場面では、形式論理証明(Formal Logic Provers)などのシンボリックAIとLLMを組み合わせる「ニューロシンボリック(Neuro-symbolic)」なアプローチが推奨されます。これにより、LLMの流暢さと、数理論理学の正確さを両立させることができます。

- 視覚モデルとの連携: 脳が視覚野を使って状況モデルを作るように、画像認識・生成モデルをLLMの「目」として統合します。これにより、テキスト情報だけでは抜け落ちてしまう空間的な文脈を補完することが可能です。

技術的視点と今後の展望

脳が言語処理において「情報の転送」を行っているという事実は、AI開発における現在の課題を突破するための重要な指針となります。

ハルシネーションの抑制

LLMが抱える最大の課題であるハルシネーション(もっともらしい嘘)は、AIが現実世界の制約を無視して、統計的な確率だけで言葉を紡ぐために発生します。脳の仕組みにならい、言語生成を行うLLMと、事実や論理を検証する外部システムを明確に切り分けるアーキテクチャを採用することで、流暢さを保ちながら正確性を担保できる可能性があります。

メモリ効率と処理能力の向上

人間の言語システムは処理能力やメモリに限界があり、情報を外部領域へ「転送」することで、その負荷を軽減しています。AIにおいても、すべての情報をLLMのコンテキストウィンドウに詰め込むのではなく、外部データベースや長期記憶モジュールへオフロードする設計が重要です。これにより、計算コストを抑えつつ、より長い文脈や複雑なタスクを維持・管理できるようになります。

「機能的コンピテンス」の獲得

Casto氏らの論文では、言語の規則を操る「形式的コンピテンス(Formal Competence)」と、言語を使って現実世界で何かを成し遂げる「機能的コンピテンス(Functional Competence)」が区別されています。現在のLLMは形式的には優秀ですが、機能的にはまだ発展途上です。脳が視覚野や運動野と連携して世界に働きかけるように、AIも様々な専門モジュールと有機的に連携することで、単なるチャットボットを超えた、真に役立つ「自律型AIエージェント」へと進化していきます。

おわりに

今回は、人間の脳が言葉を深く理解するために、情報を脳内の各専門領域へ「転送」しているというメカニズムを見てきました。私たちの「深い理解」は、言語システム単体の能力ではなく、視覚や論理、運動といった複数のシステムとの連携によって支えられています。

この知見は、今後のAI活用における重要な羅針盤となります。LLMを「万能な思考装置」として過信し、すべてを任せるのは得策ではありません。むしろ、LLMをユーザーの意図を汲み取り、適切な専門ツール(計算機やデータベース)へと繋ぐ高度な「ルーター」や「インターフェース」として再定義するべきです。

脳が適材適所で処理を分散しているように、AIシステムもまた、外部モジュールとの有機的な連携を強化することで、より実用的で信頼性の高いパートナーへと進化していくはずです。

More Information

- arXiv:2511.19757, Colton Casto et al., 「What does it mean to understand language?」, https://arxiv.org/abs/2511.19757